Pengertian

• Analisa Rantai Markov adalah suatu metode yang mempelajari sifat -sifat suatu variabel pada masa sekarang yang didasarkan pada sifat -sifatnya di masa lalu dalam usaha menaksir sifat-sifat variabel tersebut dimasa yang akan datang.

• Analisis Markov adalah suatu teknik matematik untuk peramalan perubahan pada variable-variabel tertentu berdasarkan pengetahuan dari perubahan sebelumnya.

• Model Rantai Markov dikembangkan oleh seorang ahli Rusia A.A. Markov pada tahun 1896. Dalam analisis markov yang dihasilkan adalah suatu informasi probabilistik yang dapat digunakan untuk membantu pembuatan keputusan, jadi analisis ini bukan suatu teknik optimisasi melainkan suatu teknik deskriptif . Analisis Markov merupakan suatu bentuk khusus dari model probabilistik yang lebih umum yang dikenal sebagai proses Stokastik (Stochastic process).

• Konsep dasar analisis markov adalah state dari sistem atau state transisi, sifat dari proses ini adalah apabila diketahui proses berada dalam suatu keadaan tertentu, maka peluang berkembangnya proses di masa mendatang hanya tergantung pada keadaan saat ini dan tidak tergantung pada keadaan sebelumnya, atau dengan kata lain rantai Markov adalah rangkaian proses kejadian dimana peluang bersyarat kejadian yang akan datang tergantung pada kejadian sekarang.

• Jadi, Informasi yang dihasilkan tidak mutlak menjadi suatu keputusan, karena sifatnya yang hanya memberikan bantuan dalam proses pengambilan keputusan.

Syarat-Syarat Dalam Analisa Markov

Untuk mendapatkan analisa rantai markov ke dalam suatu kasus, ada beberapa syarat yang harus dipenuhi yaitu sebagai berikut:

1. Jumlah probabilitas transisi untuk suatu keadaan awal dari sistem sama dengan 1.

2. Probabilitas-probabilitas tersebut berlaku untuk semua partisipan dalam sistem.

3. Probabilitas transisi konstan sepanjang waktu.

4. Kondisi merupakan kondisi yang independen sepanjang waktu.

Penerapan analisa markov bisa dibilang cukup terbatas karena sulit menemukan masalah yang memenuhi semua syarat yang diperlukan untuk analisa markov, terutama persyaratan bahwa probabilitas transisi harus konstan sepanjang waktu (probabilitas transisi adalah probabilitas yang terjadi dalam pergerakan perpindahan kondisi dalam sistem).

Keadaan Probabilitas Transisi

Keadaan transisi adalah perubahan dari suatu keadaan (status) ke keadaan (status) lainnya pada periode berikutnya. Keadaan transisi ini merupakan suatu proses random dan dinyatakan dalam bentuk probabilitas. Probabilitas ini dikenal sebagai probabilitas transisi. Probabilitas ini dapat digunakan untuk menentukan probabilitas keadaan atau periodeberikutnya.

Contoh Kasus :

Sebuah perusahaan transportasi mempunyai 220 unit mobil. Namun tidak semua mobil dapat beroperasi dikarenakan mesin rusak. Data mobil yang sedang beroperasi(narik) dan rusak(mogok) adalah sebagai berikut :

Dalam waktu dua hari ini terdapat perubahan, mobil yang beroperasi ternyata mengalami kerusakan, dan sebaliknya. Untuk mengetahui perubahan yang terjadi dapat dilihat pada tabel di bawah ini :

Dari data tersebut hitunglah :

a. Probabilitas transisi

b. Probabilitas hari ke-3 narik jika hari ke-1 narik

c. Probabilitas hari ke-3 mogok jika hari ke-1 narik

d. Probabilitas hari ke-3 narik jika hari ke-1 mogok

e. Probabilitas hari ke-3 mogok jika hari ke-1 mogok

Jawaban :

a. Probabilitas Transisi

Peralatan Analisis Markov

1. Probabilitas Tree

Probabilities tree merupakan cara yang aman dan sangat membantu untuk menunjukan sejumlah terbatas trasisi dari suatu proses Markov.

Dari 2 gambar tersebut, kita bisa menjawab jawab soal di atas, sehingga :

b. Probabilitas hari ke-3 narik, jika hari ke-1 narik = 0,3402 + 0,3084 = 0,6486

c. Probabilitas hari ke-3 mogok jika hari ke-1 narik= 0,2431 + 0,1083 = 0,3514

d. Probabilitas hari ke-3 narik, jika hari ke-1 mogok = 0,4316 + 0,1924 = 0,624

e. Probabilitas hari ke-3 mogok jika hari ke-1 mogok = 0,3084 + 0,0676 = 0,376

2. Pendekatan Matriks

Ada kalanya kita harus mencari probabilitas pada periode yang sangat besar, misalkan periode hari ke-9, ke-10 dan seterusnya, akan sangat menyulitkan danmembutuhkan media penyajian yang khusus jika kita menggunakan Probabilitas Tree. Oleh karena permasalahan tersebut dapat diselesaikan dengan menggunakan metode Pendekatan Matriks Probabilitas.

• Jika kendaraan pada hari ke-1 narik maka berlaku probabilitas sebagai berikut:

N(i) = 1

M(i) = 0

• Lalu probabilitas di atas disusun ke dalam vektor baris, maka kita dapatkan:

(N(i) M(i)) = (1 0)

• Adapun rumus untuk mencari probabilitas periode berikutnya (i+1) adalah:

(N(i+1) M(i+1)) = (N(i) M(i)) x Matriks Probabilitas Transisi

• Terlihat bahwa hasilnya sama dengan yang diperoleh dengan menggunakan metodeProbabilities Tree.

• Dengan menggunakan cara yang sama kita akan dapatkan status untuk periode-periode berikutnya sebagai berikut:

(N(3) M(3)) = (0,6486 0,3514)

(N(4) M(4)) = (0,6384 0,3616)

(N(5) M(5)) = (0,6400 0,3400)

(N(6) M(6)) = (0,6397 0,3603)

(N(7) M(7)) = (0,6398 0,3602)

(N(8) M(8)) = (0,6398 0,3602)

• Terlihat bahwa perubahan probabilitas semakin lama semakin mengecil sampai akhirnya tidak tampak adanya perubahan. Probabilitas tersebut tercapai mulai dari periode ke-7, dengan probabilitas status:

(N(7) M(7)) = (0,6398 0,3602)

Ini berarti pemilik kendaraan dapat menarik kesimpulan bahwa jika awalnya kendaraan berstatus narik, setelah beberapa periode di masa depan probabilitasnya narik adalah sebesar 0,6398 dan probabilitasnya mogok adalah sebesar 0,3602.

Untuk perhitungan probabilitas status hari pertama mogok dapat kita cari dengan metode yang sama dan akan kita dapatkan probabilitas yang akan sama untuk periode selanjutnya, mulai dari periode ke-8. Adapun probabilitas pada periode ke-8 adalah:

N(8) M(8)) = (0,6398 0,3602)

Keadaan Steady State dan Probabilitasnya

Dalam banyak kasus, proses markov akan menuju pada Steady State (keseimbangan) artinya setelah proses berjalan selama beberapa periode, probabilitas yang dihasilkan akan bernilai tetap, dan probabilitas ini dinamakan Probabilitas Steady State. Untuk mencari Probabilitas Steady State dari suatu Matriks Transisi, maka kita dapat menggunakan rumus:

( N(i+1) M(i+1) ) = ( N(i) M(i) ) x Matriks Probabilitas Transisi

Karena Steady State akan menghasilkan probabilitas yang sama pada periode ke depan maka rumus tersebut akan berubah menjadi:

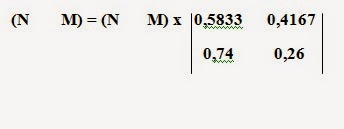

( N(i) M(i) ) = ( N(i) M(i) ) x Matriks Probabilitas Transisi

Untuk mengurangi keruwetan, periode (i) dapat kita hilangkan, karena pada saat Steady State tercapai periode tidak akan mempengaruhi perhitungan. Sehingga perhitungan di atas akan menjadi:

• Dari perhitungan di atas akan menghasilkan persamaan berikut:

N = 0,5833N + 0,74M ................................. (1)

M = 0,4167N + 0,26M ................................ (2)

• Karena salah satu ciri proses markov adalah:

N + M = 1, maka:

N + M = 1 --> M = 1 – N

Dengan mensubtitusikan M = 1 - N ke persamaan (1) didapatkan:

N = 0,5833N + 0,74M

N = 0,5833N + 0,74 ( 1 - N)

N = 0,5833N + 0,74 - 0,74N

1,1567N = 0,74

N = 0,6398

Lalu kita masukkan nilai N = 0,6398 ke dalam persamaan (2) didapatkan:

M = 1 – N

M = 1 – 0,6398

M = 0,3602

Hasilnya :

Dari contoh kasus kita ketahui bahwa Pemilik Kendaraan memiliki 220 kendaraan. Dengan menggunakan Probabilitas Steady State yang sudah kita dapatkan, Pemilik dapat mengharapkan jumlah kendaraan setiap harinya narik atau mogok sebanyak:

Narik : N x 220 = 0,6398 x 220= 140,756 ~ 141 kendaraan

Mogok : M x 220 = 0,3602 x 220= 79,244 ~ 79 kendaraan

• Misalkan Pemilik kurang puas dengan tingkat operasi yang ada dan ingin meningkatkannya, sehingga Pemilik mengambil kebijakan untuk menggunakan suku cadang asli dalam setiap perawatan armada. Kebijakan ini membuat Matriks Probabilitas Transisi berubah menjadi:

Artinya kebijakan ini membuat Probabilitas saat ini narik, lalu hari berikutnya mogok menurun dari 0,4167 menjadi 0,3. Probabilitas Steady State yang baru adalah:

• Sehingga kita dapatkan persamaan berikut:

N = 0,7N + 0,74M………………………(1)

• Substitusikan M = 1 - N ke persamaan (2), sehingga kita dapatkan:

M = 0,2885 dan N = 0,7116

Artinya setiap harinya Pemilik dapat mengharapkan kendaraan yang narik atau mogok sebanyak:

Narik : N x 220 = 0,7116 x 220 = 156,55 ~ 157 kendaraan

Mogok : M x 220 = 0,2885 x 220 = 63,47 ~ 63 kendaraan

Kebijakan tersebut menghasilkan kenaikan operasional dari 141 kendaraan perhari menjadi 157 kendaraan perhari. Dalam hal ini Pemilik harus mengevaluasi kebijakan ini, apakah kenaikan pendapatan operasional dapat menutupi kenaikan biaya operasional karena kebijakan ini.

Misalkan karena kebijakan ini terjadi kenaikan biaya perawatan kendaraan sebesar Rp. 1.000.000,- setiap harinya. Jadi bila kenaikan pendapatan operasional lebih besar dari Rp. 1.000.000,- maka kebijakan tersebut layak

Saya tertarik dengan tulisan mbak. Maaf, apa bisa diberitahukan literatur dan penulisnya yang menyebutkan syarat-syarat dalam Analisa Markov?

BalasHapusSaya tunggu jawaban mbak. Makasih.

Boleh tanya jadi apa tujuan dilakukan Analisa Markov? terutama dalam kegiatan auditing.

BalasHapusapa maksud dari "jadi analisis ini bukan suatu teknik optimisasi melainkan suatu teknik deskriptif."

Jika tidak keberatan, boleh di jelaskan mba lebih lanjut jika beberapa asumsi variabel berubah untuk proyeksinya. Trmksh

BalasHapusMenarik sekali. Saya baca 10 menit lebih mudah di pahami daripada baca jurnal 2 jam

BalasHapusMenarik sekali. Saya baca 10 menit lebih mudah di pahami daripada baca jurnal 2 jam

BalasHapusMantap

BalasHapusada g fungsinya

BalasHapusRumus termudahnya yg mana nih mbak, kalau ada matriks2 nya saya kurang paham

BalasHapusthanks mba

BalasHapus